Le persone hanno difficoltà a riconoscere i volti reali

Testo, audio, immagini e video generati dall’intelligenza artificiale (I.A.) sono spesso utilizzati per immagini sessuali non consensuali, frodi finanziarie e campagne di disinformazione, così come per il revenge porn e la propaganda politica.

I contenuti generati dalle I.A. hanno la capacità di intrattenere, ma anche di ingannare: dal simulare il parlato di qualsiasi voce a produrre un’immagine di una persona fittizia e scambiarne l’identità con un’altra, o manipolare ciò che si sta dicendo in un video.

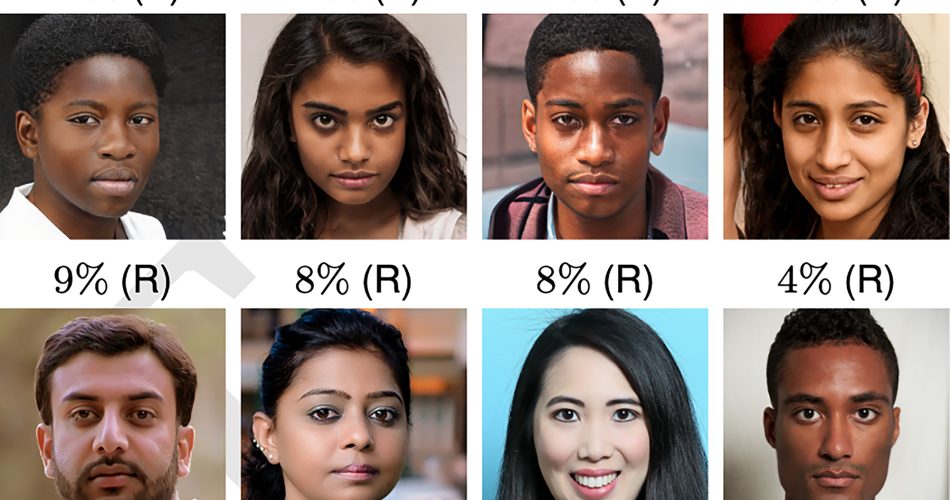

La dottoressa Sophie Nightingale dell’Università di Lancaster e il professor Hany Farid dell’Università della California, Berkeley, hanno condotto dei test in cui è stato chiesto ai partecipanti di riconoscere la differenza tra i volti generati artificialmente da StyleGAN2 e quelli reali, così come il livello di fiducia che i volti suscitavano.

I risultati hanno mostrato che i volti generati artificialmente non sono solo foto-realistici, ma sono anche quasi indistinguibili dai volti reali. In più, sono considerati anche più affidabili.

“La nostra valutazione del fotorealismo dei volti artificiali indica che i motori di sintesi hanno superato la cosiddetta “zona perturbante” e sono in grado di creare volti che sono indistinguibili – e più affidabili – dei volti reali”.

Le reti generative avversarie (GAN) consistono in due reti neurali contrapposte, un generatore e un discriminatore. Il generatore parte da un array casuale di pixel e impara iterativamente a simulare un volto realistico per creare l’immagine di una persona fittizia. Il discriminatore impara a differenziare il volto sintetizzato da un corpus di volti reali ad ogni iterazione; se il volto sintetizzato è identificabile rispetto a quelli reali, il generatore viene penalizzato.

I ricercatori avvertono che l’incapacità delle persone di riconoscere le immagini generate dall’intelligenza artificiale può avere gravi conseguenze.

“Forse la più pericolosa è la situazione in cui, in un mondo digitale in cui qualsiasi immagine o video può essere falsificato, l’autenticità di qualsiasi registrazione scomoda o sgradita può essere messa in discussione”.

- Nel primo test, è stato chiesto a 315 persone di classificare 128 volti da un totale di 800, come reali o falsi. La loro percentuale di precisione è stata del 48%.

- Altri 219 volontari sono stati addestrati e hanno ricevuto un feedback su come classificare i volti in un secondo esperimento. Hanno così classificato 128 volti dalla stessa sequenza degli 800 come nel primo test, ma il tasso di precisione è migliorato solo al 59% nonostante il loro addestramento.

Così, i ricercatori hanno voluto vedere se la percezione di affidabilità delle persone avrebbe potuto aiutarle a individuare le foto false.

“I volti forniscono una ricca fonte di informazioni, con un’esposizione di pochi millisecondi sufficiente a fare inferenze implicite sui tratti individuali come l’affidabilità. Ci siamo chiesti se i volti artificiali attivano gli stessi giudizi di affidabilità. In caso contrario, la percezione dell’affidabilità potrebbe aiutare a distinguere i volti reali da quelli artificiali”.

Pertanto, in un terzo studio, a 223 individui è stato chiesto di stimare l’attendibilità di 128 volti da una serie degli stessi 800 volti utilizzati in precedenza su una scala da 1 (altamente inaffidabile) a 7 (molto attendibile).

L’affidabilità media dei volti artificiali era del 7,7% superiore all’affidabilità media dei volti autentici, il che risulta statisticamente significativo.

“Forse la cosa più interessante è che si riscontra che i volti generati artificialmente sono più affidabili di quelli reali”.

Inoltre, i volti degli afro-americani sono stati valutati come più affidabili rispetto a quelli dei sud-asiatici, ma non c’erano altre differenze nelle valutazioni, mentre le donne erano considerate molto più affidabili degli uomini.

“Un volto sorridente ha maggiori probabilità di essere valutato come affidabile, ma il 65,5% dei volti reali e il 58,8% dei volti artificiali sono sorridenti, quindi l’espressione facciale da sola non può spiegare perché i volti artificiali siano valutati come più affidabili”.

I volti artificiali, secondo i ricercatori, possono essere percepiti come maggiormente affidabili poiché assomigliano alle caratteristiche di volti mediamente considerati più affidabili.

In ogni caso, per salvaguardare le persone dai “deep fake”, sono stati stabiliti anche degli standard per la creazione e la condivisione di immagini artificiali.

Le misure di sicurezza potrebbero includere: incorporare solide filigrane nelle reti di sintesi di immagini e video che fornirebbero un meccanismo a valle per un’identificazione accurata. Alcuni suggeriscono anche di ripensare all’approccio troppo permissivo alla pubblicazione libera del codice, dato che chiunque potrebbe incorporarlo in qualsiasi applicazione, così si pensa che sia l’eccessiva democratizzazione di questa potente tecnologia ad offrire la più grande minaccia.

“In questo momento cruciale, e come hanno fatto anche altri campi scientifici e ingegneristici, incoraggiamo la comunità di grafica e comunicazione visiva a sviluppare linee guida per la creazione e la distribuzione di tecnologie di media artificiali che incorporino linee guida etiche per ricercatori, editori e distributori di media”.

Come abbiamo già parlato in precedenza, i rischi dei deepfake sono parte della cosiddetta fake society (società falsa) nella quale non possiamo distinguere ciò che è reale da ciò che è falso poiché l’intelligenza artificiale può manipolare quasi tutto. Comunque, non credo che una minore democratizzazione dell’accesso a questa tecnologia sarebbe la soluzione per ridurre i rischi poiché questo potrebbe portare a monopolizzare tale tecnologia nelle mani di pochi, il che sarebbe ancora più pericoloso. Penso che questa sarà una battaglia dove ci saranno I.A. contro I.A. che ci aiuteranno a contrastare la pericolosità delle prime. Tuttavia, è spaventoso come la nostra percezione innata possa essere ingannata da una I.A. Questo potrebbe significare che potremmo essere ingannati su qualcosa senza esserne consapevoli.

Fonte neurosciencenews.com