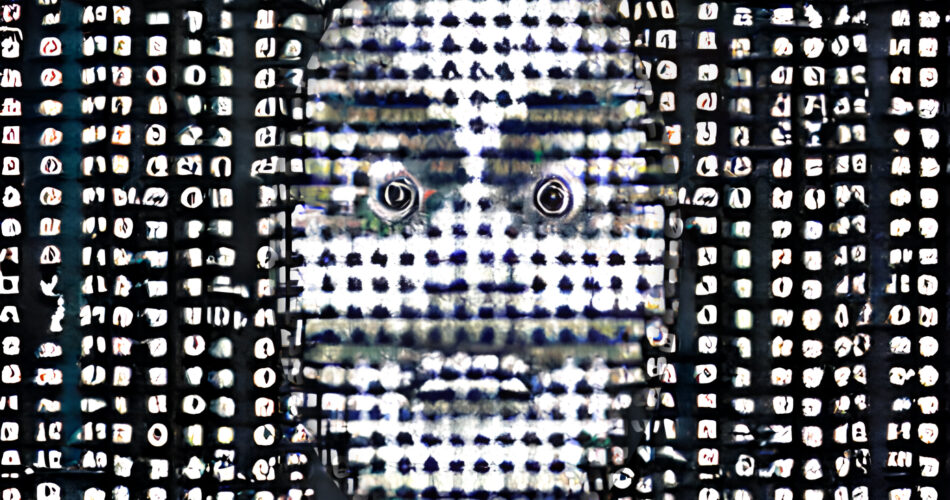

Le sue risposte possono essere ingannevoli

Sam Altman, CEO di OpenAI, ha messo in guardia gli utenti con un tweet sorprendentemente diretto su ChatGPT, il “modello interattivo e conversazionale” costruito sul generatore di testo GPT-3.5 dell’azienda:

“ChatGPT è incredibilmente limitato, ma è abbastanza valido in alcune cose da creare un’impressione fuorviante di eccellenza”, ha twittato. “È un errore fare affidamento su di esso per qualsiasi cosa importante in questo momento. È un’anteprima del progresso; abbiamo molto lavoro da fare sulla robustezza e sulla veridicità”.

Pur avvertendo che ChatGPT, al momento del lancio di OpenAI, era una versione demo e di ricerca preliminare con “molte limitazioni”, ne ha comunque esaltato i suoi potenziali utilizzi nei seguenti modi: “Presto potrete avere assistenti affidabili che vi parlano, rispondono alle domande e danno consigli”, ha twittato. “In seguito potrete avere qualcosa che va a svolgere dei compiti per voi. Infine, anche qualcosa che va a scoprire nuove conoscenze per voi”.

Tuttavia, secondo questo articolo, ChatGPT ha un difetto nascosto: emette rapidamente risposte eloquenti e sicure di sé che spesso sembrano credibili e veritiere anche se non lo sono. ChatGPT inventa fatti, proprio come altri grandi modelli linguistici generativi. Alcuni lo definiscono “allucinazione” o “imitazione stocastica”, ma questi modelli sono addestrati ad anticipare la parola successiva in base a un input piuttosto che a determinare se un fatto è vero o meno.

Alcuni hanno osservato che ChatGPT si distingue perché è così abile nel far sembrare plausibili le sue allucinazioni. Benedict Evans, un analista tecnologico, per esempio, ha chiesto a ChatGPT di “scrivere una biografia per Benedict Evans”. Egli ha poi twittato che il risultato era “plausibile, ma quasi del tutto falso”.

Ancora più preoccupante è il fatto che ci siano innumerevoli richieste per le quali l’utente sarebbe in grado di determinare se la risposta è falsa solo se conoscesse già la risposta alla richiesta presentata. Il professore di informatica di Princeton, Arvind Narayanan, ha fatto la seguente osservazione in un tweet: “Le persone sono entusiaste di usare ChatGPT per l’apprendimento. Spesso è molto buono., ma il rischio è che non si può capire quando sbaglia, a meno che non si conosca già la risposta. Ho provato alcune domande di base sulla sicurezza informatica. Nella maggior parte dei casi, le risposte sembravano plausibili, ma in realtà erano stronzate”.

In ogni caso, non ci sono prove che la domanda si utilizzo di questo strumento sia in calo: Anzi, sembra che OpenAI abbia difficoltà a soddisfare le richieste. Alcuni sostengono di aver ricevuto un messaggio che recita: “Ehi! Potresti dover aspettare un po’. Al momento stiamo ricevendo più richieste di quante ne possiamo gestire”.

Sembra che coloro che creano questi modelli stiano tenendo la testa bassa poiché sono consapevoli dell’intensa concorrenza che li attende, nonostante il ritmo frenetico dei discorsi che circondano ChatGPT, che vanno da quelli che criticano Google per il presunto ritardo nello sviluppo nel campo degli LLM (Large Language Models) alle preoccupazioni per il futuro dei saggi universitari.

Tuttavia, sembra che Google non abbia mai mostrato alcuna funzionalità in stile ChatGPT nei suoi prodotti in quanto sarebbe troppo costosa e i risultati non sarebbero buoni come una ricerca classica, anche a causa della latenza di risposta.

Dal punto di vista di OpenAI, è evidente che l’azienda stia sfruttando questo periodo di ampia sperimentazione della comunità con ChatGPT per ottenere l’RLHF (Reinforcement Learning from Human Feedback) per l’attesissimo rilascio di GPT-4. Pertanto, più persone utilizzano ChatGPT, più l’algoritmo sarà addestrato.

Naturalmente, anche se il CEO di Stability AI, Emad Mostaque, fa questa affermazione, egli parla anche a nome di coloro che stanno sviluppando freneticamente una versione open-source di ChatGPT.

Uno degli sviluppatori di Stable Diffusion (uno dei tre famosi generatori di immagini di IA, tra cui DALL-E e Midjourney), LAION, sostiene di essere attivamente impegnato in questo senso.

Questo nuovo strumento mette in luce uno dei principali problemi delle IA, ovvero l’inganno. Non è detto che l’azienda che l’ha sviluppata lo faccia apposta, ma ciò accade a causa del funzionamento dell’algoritmo. Se statisticamente una sequenza di parole o di richieste ha maggiori probabilità di produrre un certo tipo di risultato, l’IA lo mostrerà perché attraverso l’addestramento è stato così. Ma il problema è che le persone si fideranno inevitabilmente di uno strumento comodo, facile da usare e coinvolgente. Pertanto, senza un pensiero critico, le persone apprenderanno informazioni false. Immaginate questa reazione a catena che si espande a livello globale. Le persone penseranno di sapere qualcosa che non è vero e la loro coscienza sarà alterata.

Al contempo, anche quando le persone verrebbero corrette per aver detto qualcosa di sbagliato, come in una scuola, potrebbero usare questo strumento per superare un test laddove l’IA rispondesse correttamente.

In ogni caso, questo strumento migliorerà e darà risultati sempre migliori, ma le persone dovrebbero imparare a non accettare una risposta solo perché è più facile da ottenere o proviene da una fonte che ci piace.