La battaglia contro i deepfake è iniziata

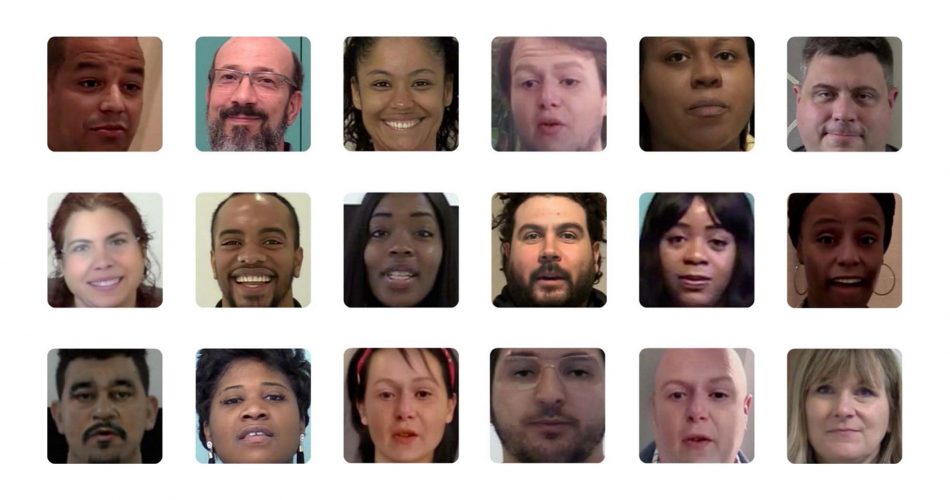

I deepfake stanno aumentando rapidamente e in diversi ambiti, fin dai primi esperimenti in cui abbiamo visto sostituzioni di teste di attori con quelle di altre persone, o peggio quando questa tecnica è stata applicata ai film porno con la conseguenza di far credere che alcune celebrità avessero davvero recitato in quel tipo di film.

Se prima questi deepfake erano a volte riconoscibili, ora con reti neurali sempre più potenti, sembrano ancora più reali, anche se ancora non perfetti è facile immaginare che saranno sempre più utilizzati per creare identità false, soprattutto nei profili dei vari social.

Facebook sa che questo accadrà, quindi sta lavorando per arginare il problema e trovare una soluzione.

Il loro ultimo lavoro è una collaborazione con gli accademici della Michigan State University (MSU), con un gruppo combinato per creare un processo di retroingegneria dei deepfakes: analizzare le immagini generate dall’IA per rivelare le caratteristiche identificative del modello di apprendimento automatico che è stato creato.

Al momento, il lavoro è ancora in fase di ricerca e non è pronto per essere distribuito.

I metodi attuali si concentrano sul determinare se un’immagine è reale o un deepfake (rilevamento), o sull’identificare se un’immagine è stata generata da un modello già visto durante un addestramento o meno dell’IA (attribuzione dell’immagine tramite classificazione). Ma per risolvere il problema della proliferazione dei deepfake è necessario fare un ulteriore passo avanti nella discussione, poiché un deepfake può essere creato utilizzando un modello generativo che non è stato mai osservato durante un addestramento dell’IA.

La retro-ingegneria è un modo diverso di affrontare il problema dei deepfake, ma non è un concetto nuovo nel machine learning.

Generalizzando l’attribuzione delle immagini si possono dedurre più informazioni sul modello generativo utilizzato per creare un deepfake che va oltre il riconoscimento di qualcosa mai visto in precedenza. E tracciando le somiglianze tra i modelli di una collezione di deepfake, si potrebbe anche stabilire se una serie di immagini ha avuto origine da un’unica fonte.

Questo lavoro, guidato da Vishal Asnani della MSU, identifica i tratti architettonici dei modelli sconosciuti. Questi tratti, noti come iperparametri, devono essere regolati in ogni modello di apprendimento automatico, dato che lasciano un’impronta digitale unica sull’immagine finita che può poi essere utilizzata per identificare la sua fonte.

I ricercatori hanno iniziato eseguendo un’immagine deepfake attraverso una Rete di Stima delle Impronte Digitali (Fingerprint Estimation Network) per valutare i dettagli dell’impronta digitale lasciata dal modello generativo. Le impronte digitali dei dispositivi sono modelli sottili, ma unici, lasciati su ogni immagine prodotta da un particolare dispositivo a causa di imperfezioni nel processo di produzione. Nella fotografia digitale, le impronte digitali sono utilizzate per identificare la fotocamera digitale utilizzata per produrre un’immagine.

Dal momento che il software per i deepfake è estremamente facile da personalizzare, identificare i tratti dei modelli sconosciuti è importante, come ha detto Tal Hassner, leader della ricerca di Facebook. Questo permette potenzialmente ai malintenzionati di coprire le loro tracce se si tentasse di rintracciare la loro attività.

Le impronte sono state stimate utilizzando diversi vincoli basati sulle proprietà di un’impronta digitale generica, tra cui: la grandezza dell’impronta, la natura della ripetizione, la gamma di frequenza e la risposta in frequenza simmetrica.

“Supponiamo che un malintenzionato stia generando un sacco di deepfake diversi e li carichi su diverse piattaforme per diversi utenti”, ha affermato Hassner. “Se questo fosse un nuovo modello di IA che nessuno abbia mai visto prima, allora avremmo poche informazioni precedenti su di esso. Ora, siamo in grado di dire, ‘Guarda, la foto che è stata caricata qui, la foto che è stata caricata lì, tutte provengono dallo stesso modello’, E se fossimo in grado di sequestrare il portatile o il computer [usato per generare il contenuto], saremo in grado di dire, ‘Questo è il colpevole'”.

Hassner paragona questo lavoro alle tecniche forensi utilizzate per identificare quale modello di macchina fotografica è stato utilizzato per scattare una foto, cercando modelli nell’immagine risultante. “Non tutti possono creare la propria macchina fotografica, però”, dice. “Mentre chiunque con una ragionevole quantità di esperienza e un computer standard può preparare il proprio modello che genera deepfakes”.

Non solo l’algoritmo risultante può rilevare i tratti di un modello generativo, ma può anche identificare quale modello conosciuto ha creato un’immagine e se si tratta di un deepfake.

Tuttavia è importante notare che anche questi risultati avanguardistici sono tutt’altro che affidabili. Quando Facebook ha tenuto una gara di rilevamento di deepfake l’anno scorso, l’algoritmo vincitore è stato in grado di rilevare i video manipolati dall’IA solo il 65,18% delle volte. I ricercatori coinvolti hanno detto che individuare i deepfake usando gli algoritmi è ancora un “problema irrisolto”.

Parte della ragione è che il campo dell’IA generativa è estremamente attivo. Nuove tecniche vengono pubblicate ogni giorno, ed è quasi impossibile per qualsiasi filtro tenere il passo.

Coloro che sono coinvolti in questo settore sono perfettamente consapevoli di questa dinamica, e quando gli viene chiesto se la pubblicazione di questo nuovo algoritmo di identificazione porterà a ricerche che possono passare inosservate a causa di questi metodi, Hassner è d’accordo. “Mi aspetterei di sì”, dice. “Questo è un gioco del gatto e del topo, e continua ad essere un gioco del gatto e del topo”.

I deepfake stanno stravolgendo il mondo digitale. Se nel campo cinematografico, grafico e videoludico saranno davvero una rivoluzione. I problemi che sorgeranno per via delle false identità saranno innumerevoli. È quindi giusto che ci sia un’arma per controbattere il cattivo uso di questo mezzo. Ciononostante bisogna anche immaginare i lati positivi di una falsa identità. Se consideriamo le eccessive violazioni di privacy o di paesi con un’elevata censura, una falsa identità potrebbe aiutare chi rischia nel manifestare le proprie idee liberamente o chi non vuole lasciare troppe tracce di sé. Cosa ben diversa dal rubare l’identità altrui dato che grazie ai nuovi algoritmi è possibile creare un volto realistico senza che esso sia mai esistito.

Come sempre ogni tecnologia è pericolosa o vantaggiosa, dipende dal contesto in cui ci si trova.

Fonte theverge.com; facebook